Vor Zurück Inhalt

11. Ein neues Paradigma?

Der Ansatz, Emotionen als eine Eigenschaft der Architektur eines intelligenten Systems anzusehen, hat in den letzten Monaten zu einem vermehrten Interesse an diesem Thema geführt. Wurden 1997 auf den führenden Weltkongressen zum Thema "Agenten" nur insgesamt zwei Papiere mit dem Thema Emotion vorgestellt, gab es 1998 bereits einen ersten Kongreß ausschließlich zum Thema "Intelligente Agenten"

Eine Reihe von Forschern hat damit begonnen, auf der Grundlage der von Simon, Toda und auch Sloman vorgeschreibenen Prinzipien emotionale autonome Agenten zu entwickeln. Viele dieser Ansätze befinden sich noch auf der Stufe der theoretischen Exploration; einig sind rudimentär bereits implementiert worden.

Eine grundlegende Gemeinsamkeit aller agentenzentrierten Ansätze ist die Auffassung von Emotionen als Kontrollsignale in einer Architektur, die ein System besitzen muß, daß sich selbständig in einer unsicheren Umwelt bewegt. Die Funktion von Emotionen ist es, die Aufmerksamkeit des Systems auf einen externen oder internen Aspekt zu richten, der eine Bedeutung für wesentliche Ziele oder Anliegen des Systems besitzt und diesem damit Verarbeitungspriorität zuzusichern.

11.1. Die Modelle von Velásquez

11.1.1. Cathexis

Velásquez (1997) hat ein Modell entwickelt, das auf der "Society of Mind"-Theorie von Minsky (1985) basiert. Er nennt es Cathexis, einen Begriff, den er als "concentration of emotional energy on an object or idea" definiert (Velásquez, 1997, S.10).

Emotionen bestehen in seinem Modell aus einer Vielfalt von Subsystemen:

Jeder dieser Proto-Spezialisten verfügt über vier Arten von Sensoren, die für die Messung internaler und externaler Zustände verantwortlich sind: Neuronale Sensoren, sensorimotorische Sensoren, motivationale Sensoren und kognitive Sensoren. Außerdem ist jeder Proto-Spezialist durch zwei Schwellenwerte gekennzeichnet, die Velásquez als Alpha und Omega bezeichnet: Alpha ist die Schwelle, oberhalb derer die Aktivation des jeweiligen Proto-Spezialisten einsetzt; Omega ist die Saturationsgrenze eines Proto-Spezialisten. Schließlich verfügt jeder Proto-Spezialist noch über eine decay function, welche die Dauer seiner Aktivierung beeinflußt.

Velásquez unterscheidet in seinem Modell zwischen basic emotions und emotion blends/mixed emotions. Bei der Definition der basic emotions stützt er sich auf Ekman und Izard und definiert sie wie folgt:

Die basic emotions in Cathexis sind Anger, Fear, Distress/Sadness, Enjoyment/Happiness, Disgust und Surprise.

Emotion blends bzw. mixed emotions sind emotionale Zustände, die entstehen, wenn mehrere unterschiedliche emotionale Proto-Spezialisten, welche die basic emotions repräsentieren, aktiv sind, ohne daß einer von ihnen die anderen dominiert.

Schließlich kennt das Modell auch noch moods, die sich von den Emotionen allein durch die Höhe des Erregungsniveaus unterscheiden.

Emotionen werden in Cathexis hervorgerufen durch kognitive und nicht-kognitive elicitors, die aus den selben Kategorien stammen wie die Sensoren des Systems. Die cognitive elicitors für die basic emotions basieren dabei auf einer modifizierten Version von Rosemans Emotionsmodell.

Die Intensität einer Emotion wird in Velásquez' Modell durch mehrere Faktoren beeinflußt:

Das Verhaltensrepertoire des Systems kennt drei wesentliche Elemente: eine expressive component, mit deren Hilfe es seinen gegenwärtigen emotionalen Zustand mitteilt, bestehend aus Gesicht, Körper und Stimme; eine experiential component, die aus Erfahrungen lernt und sich auswirkt auf Motivationen und Handlungstendenz des Systems sowie einen Handlungsselektionsmechanismus, der aufgrund der kalkulierten behavior values unterschiedlicher Handlungsalternativen diejenige mit dem höchsten Wert auswählt.

Das System durchläuft regelmäßig sogenannte update cycles, in denen folgender Kreislauf abgewickelt wird:

Velásquez hat Cathexis in Form eines Computermodells implementiert, das er "Simón the Toddler" nennt. Der Bildschirm zeigt dabei das Gesicht eines Säuglings, das zu unterschiedlichen emotionalen Ausdrucksweisen und rudimentären Verbalisierungen fähig ist. Der Benutzer interagiert mit dem System, indem er zum Beispiel die Parameter von Simóns Proto-Spezialisten verändert, das Level der Neurotransmitter variiert oder direkt mit ihm interagiert, indem er ihn füttert, streichelt usw.

Derzeit verfügt das Modell über 5 Trieb-Proto-Spezialisten (Hunger, Durst, Temperaturregulation, Ermüdung, Interesse) und ein Repertoire von 15 Verhaltensalternativen, darunter Schlafen, Essen, Trinken, Lachen, Weinen, Küssen und mit Spielzeug spielen. Diese sollen im Zuge der weiteren Modellentwicklung Schritt um Schritt erweitert werden.

11.1.2. Yuppy

Yuppy ist ein Roboter, der ein emotionales Haustier darstellt. Er ist eine Weiterentwicklung des Modells Simón the Toddler. Yuppy wurde zunächst als virtuelle Simulation entwickelt, bevor er einen Körper erhielt. Velásquez nennt ihn ein Beispiel für ein System mit emotion-based control.

Das Modell ist aus einer Reihe von computational units zusammengesetzt, die aus drei Hauptkomponenten bestehen: einem Input, einem Einschätzungsmechanismus und Outputs. Ein wesentlicher Teil des Einschätzungsmechanismus sind die Releasers. Sie filtern Sinnesdaten und identifizieren besondere Bedingungen, aufgrund derer sie dann exzitatorische oder inhibitorische Signale an die mit ihnen verbundenen Subsysteme senden.

Velásquez folgt Damasio und LeDoux und unterscheidet zwischen natürlichen und erlernten Releasers. NaturalReleasers sind fest in das System eingebaut (hard-wired); Learned Releasers sind erlernt und repräsentieren Reize, die mit dem Auftreten von Natural Releasers assoziiert sind bzw. deren Auftreten vorhersagen können. In der Sprache anderer Modelle entsprechen die Natural Releasers den primären Emotionen, während Learned Releasers identisch sind mit sekundären Emotionen. Letztere erfordern mehr Verarbeitungskapazität und sind komplexer, da sie unter anderem auf persönlichen emotionalen Erinnerungen beruhen, die aktiviert werden müssen.

Triebe sind bei Yuppy motivationale Systeme, die den Agenten zur Handlung treiben. Triebsysteme sind klar unterschieden von Emotionssystemen.

Yuppys Emotionssysteme repräsentieren sechs Gruppen affektiver Basisreaktionen: Anger, Fear, Distress/Sadness, Enjoyment/Happiness, Disgust und Surprise. Velásquez unterscheidet dabei zwischen kognitiven und nicht-kognitiven Releasers von Emotionen. Er unterschiedet vier Gruppen:

- Die neuronale Gruppe umfaßt die Effekte von Neurotransmittern, Gehirntemperatur und anderen neuroaktiven Agenten, die zu einer Emotion führen können und die durch Hormone, Schlaf, Ernährung und Umweltbedingungen beeinflußt werden.

- Die sensorimotorische Gruppe umfaßt sensorimotorische Prozesse wie Gesichtsausdrücke, Körperhaltung und Muskelpotential, die nicht nur bestehende Emotionen regulieren, sondern auch Emotionen hervorrufen können.

- Die motivationale Gruppe umfaßt alle Motivationen, die zu einer Emotion führen.

- Die kognitive Gruppe umfaßt alle Arten von Kognitionen, die Emotionen aktivieren, z.B. Einschätzungen von Ereignissen, Vergleiche, Attributionen, Wünsche, Überzeugungen oder Erinnerungen.

Yuppys Wahrnehmungssystem besteht aus zwei Farb-CCD-Kameras als Augen; einem Stereo-Audio-System mit 2 Mikrophonen als Ohren; Infrarotsensoren für die Entdeckung von Hindernissen; einem Luftdrucksensor, um Berührungen zu simulieren; einem Pyrosensor, der Veränderungen der Raumtemperatur wahrnimmt, wenn Menschen den Raum betreten sowie einem einfachen propriozeptiven System.

Yuppys Triebsystem umfaßt vier Triebe (drives): Aufladeregulierung, Temperaturregulierung, Ermüdung und Neugier. Jeder dieser Triebe kontrolliert eine ihm zugeordnete interne Variable, welche den Ladezustand der Batterie, die Höhe der Temperatur, die Menge an Energie und das Maß des Interesses des Agenten repräsentieren.

Yuppys Emotionserzeugungssystem besteht aus emotionalen Systemen mit Natural Releasers für die Basisemotionen. Velásquez unterteilt die emotionalen Systeme in drei Gruppen:

| Interactions with Drive Systems: Unbefriedigte Triebe erzeugen Distress und Anger; überbefriedigte Triebe produzieren Distress, und Triebbefriedigung erzeugt Happiness. | |

| Interactions with the environment: Alle Objekte mit rosa Farbe erzeugen Happiness in unterschiedlichem Maß; gelbe Objekte produzieren Disgust. Dunkelheit erzeugt Fear und laute Geräusche Surprise. | |

| Interactions with People: Menschen können Yuppy tätscheln und disziplinieren. Dies erzeugt entweder Freude oder Schmerz. Freude führt zu Happiness; Schmerz produziert Distress und Anger. |

Yuppys Verhaltenssystem besteht aus einem verteilten Netz aus etwa 19 unterschiedlichen Verhaltensarten, die vorwiegend die Befriedigung seiner Bedürfnisse und die Interaktion mit Menschen zum Inhalt haben. Beispiele für solche Verhalten sind "search for bone", "approach bone", "recharge battery" oder "approach human".

Wie die Triebsysteme und die emotionalen Systeme verfügen auch Yuppys Verhaltenssysteme über ihre eigenen Releasers.

Der User kann Yuppys affektiven Stil durch die Manipulation von Parametern wie Schwellenwerte, inhibitorische oder exzitatorische Verbindungen usw. kontrollieren. Außerdem kann er dem Roboter innere und äußere Reize darbieten. Velásquez beschreibt das Resultat so:

Yuppy ist zudem in der Lage, sekundäre Emotionen zu lernen, welche als neue oder modifizierte kognitive Releasers gespeichert werden. Wenn zum Beispiel ein Mensch einen Knochen in der Hand hat und Yuppy dazu bringt, herbeizukommen und ihn zu holen, kann er ihn anschließend streicheln oder disziplinieren. Je nach Erlebnis produziert Yuppy eine positive oder negative emotionale Erinnerung im Hinblick auf Menschen, die wiederum sein folgendes Verhalten beeinflußt.

11.2. Das Modell von Foliot und Michel

Foliot und Michel (1998) definieren Emotionen als ein "evaluation system operating automatically either at the perceptual level or at the cognition level, by measuring efficiency and significance" (Foliot und Michel, 1998, S. 5). Für sie bilden Emotionen die Grundlage jeder Kognition. Ziel ihres Modells ist es daher, zu zeigen, "how emotion based structures could contribute to the emergence of cognition by creating suitable learning conditions" (Foliot und Michel, 1998, S. 1).

Das Modell wurde in einem virtuellen Khepera-Roboter implementiert. Khepera ist ein Miniatur-Robotermodell, das über eine Reihe von Sensoren verfügt und je nach Anspruch um weitere Komponenten erweitert werden kann. Der "Webots Simulator" simuliert nicht nur einen Khepera; mit Webots entwickelte Programme können direkt in einen Khepera übertragen werden.

Die Umgebung des virtuellen Khepera besteht aus einer Stadt mit Gebäuden, einem Fluß und Grünflächen. Jedes dieser Elemente besitzt eine spezifische Farbe. Der Roboter muß sich durch die Stadt bewegen und dabei lernen, unterschiedlichen Arten von Hindernissen auszuweichen.

Foliot und Michel repräsentieren Emotionen auf zwei Ebenen. Die Prozeßebene (level of process) kann Reize evaluieren und unterschiedliche Emotionen auslösen; die Zustandsebene (level of state) kann Informationen über das System liefern.

Die Grundlage ihres ersten Experiments war für Foliot und Michel die Annahme, daß eine Emotion charakterisiert ist durch eine Reaktion auf ein positives oder negatives Signal. Das Modell besteht aus vier Komponenten:

- Eine Reflexstruktur, die zu einer motorischen Bewegung in entgegengesetzter Richtung zu einem Hindernis führt, das von einem Infrarotsensor entdeckt wird.

- Eine Assoziationsmatrix zwischen dem motorischen Verhalten und dem Input der Infrarot-Sensoren, deren Anfangswert auf Null gesetzt ist.

- Ein Signal, das jedesmal, wenn der Roboter auf ein Hindernis trifft, eine Assoziation in der Matrix produziert.

- Ein Verhaltenssystem mit den drei Alternativen: (a) Geradeausbewegung, wenn kein Hindernis im Weg steht und keine gelernte Assoziation aktiv ist; (b) die Auslösung eines Reflexverhaltens beim Auftreffen auf ein Hindernis; (c) Assoziation einer motorischen Konfiguration mit einem bekannten Sinnesmuster.

Das Experiment ergab, daß der Roboter allmählich weniger und weniger mit Hindernissen zusammenstieß, aber sich niemals ganz fehlerfrei bewegen konnte. Um zu überprüfen, ob die Verbesserung des Lernsystems durch affektive Signale bessere Ergebnisse erbringen würde, führten die Autoren ein zweites Experiment durch.

Das zweite Experiment stützt sich auf die Emotionstheorie von Scherer. Es besteht aus fünf Komponenten:

- Ein lineares Evaluationssystem, das mit Scherers SEC korrespondiert und bei dem jede Evaluationsstufe für die nachfolgende Evaluation verwendet wird.

- Zwei Zustandssysteme, von denen eines die Einschätzung einer Situation repräsentiert, das andere den physischen Körper.

- Zwei kognitive Prozesse, von denen der eine zuständig ist für Aufmerksamkeitsselektion, der andere für die Entscheidung über die nächste Bewegung. Die Zustandssysteme können diese Prozesse direkt beeinflussen.

- Eine Datenbank mit Zielen.

- Eine sensorimotorische, eine schematische und eine konzeptionelle Ebene. Die schematische Ebene produziert Assoziationsschemata zwischen signifikanten Mustern und Handlungen.

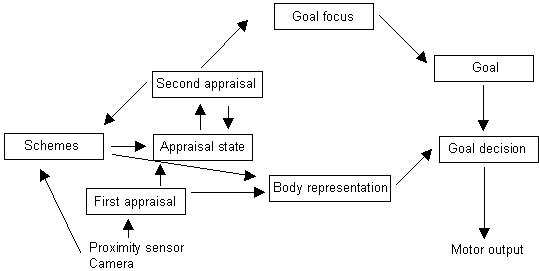

Abb. 17: Controller-Modell von Foliot und Michel (nach Foliot und Michel, 1998, S. 4)

Das Modell unterscheidet zwischen kognitiven und emotionalen Prozessen. Jeder emotionale Prozess wird durch eine Einschätzungssequenz definiert, welche Reize nach den Kriterien novelty, pleasantness, goal significance und coping klassifiziert. Jede Stufe dieses Prozesses verwendet dabei die Ergebnisse der vorhergehenden Stufen als Input. Coping kennt dabei die Alternativen "Reaktionsmöglichkeit" und "keine Reaktionsmöglichkeit".

Die kognitiven Prozesse kennen ein primäres Ziel (Vorwärtsbewegung) und vier sekundäre Ziele (Linksdrehung, Rechtsdrehung, linker Wand folgen, rechter Wand folgen). Jedes Ziel wird durch einen Wert in der Körperrepräsentation definiert.

Lernen geschieht in diesem Modell immer dann, wenn der durchschnittliche Zustand des Systems einen starken displeasure-Wert enthält:

Zentraler Bestandteil des Modells ist der Mechanismus, der Schemata produziert. Die Durchführung des Experiments ergab, daß bei der Vermeidung von Hindernissen dies entweder auf der sensorimotorischen Ebene stattfand, wenn ein Hindernis von den Infrarotsensoren wahrgenommen wurde, oder auf der schematischen Ebene, wenn ein Hindernis nicht wahrgenommen wurde. Die schematische Ebene korrespondiert mit einem vorübergehenden Zielwechsel, den die Autoren als Folge eines Gefahrensignals oder eines internen Einschätzungsprozesses interpretieren.

Bezüglich des Lernprozesses zeigte das System in seinem Verhalten zwei fundamentale Instabilitäten: Entweder beharrte der Roboter auf seinem einmal gewählten Ziel oder er wechselte seine Ziele pausenlos. Dennoch schlußfolgern Foliot und Michel, daß ihr Ansatz grundsätzlich korrekt ist, jedoch eine nähere Definition der einzelnen Komponenten erfordert.

11.3. Das Modell von Gadanho und Hallam

Gadanho und Hallam haben untersucht, welche Rolle Emotionen bei einem autonomen Roboter spielen, der sich durch Verstärkungslernen an seine Umwelt anpaßt (Gadanho und Hallam, 1998). Zu diesem Zweck arbeiteten sie mit einem simulierten Khepera-Roboter.

Ihr Emotionsmodell modellierten die Autoren nach der von Damasio (1994) vorgeschlagenen somatic marker hypothesis. Damasio nimmt an, daß Emotionen spezielle Körpergefühle hervorrufen. Diese Körpergefühle sind das Ergebnis von Erfahrungen mit internen Präferenzsystemen und externen Ereignissen und helfen dabei, Resultate bestimmter Szenarios vorherzusagen. Auf diese Weise sollen somaticmarkers Menschen dabei helfen, schnelle Entscheidungen zu treffen, ohne eine hohe Verarbeitungskapazität und lange Zeit zu beanspruchen.

Das auf dieser Grundlage von Gadanho und Hallam entwickelte Modell kennt vier grundlegende Emotionen: Happiness, Sadness, Fear und Anger. Die Intensität jeder Emotion wird durch die internen Gefühle (feelings) des Roboters bestimmt. Diese Gefühle sind: Hunger, Pain, Restlessness, Temperature, Eating, Smell, Warmth und Proximity. Jede Emotion ist definiert durch ein Set konstanter Gefühlsabhängigkeiten und einen Bias-Wert. So ist zum Beispiel die Intensität von Sadness hoch, wenn Hunger und Restlessness hoch sind und der Roboter nicht ißt.

Im Modell von Gadanho und Hallam versucht jede Emotion den Körperzustand (body state) so zu beeinflussen, daß der resultierende Körperzustand dem gleicht, der jene spezifische Emotion hervorruft. Dazu benutzt die Emotion ein einfaches hormonelles System. Mit jedem Gefühl ist ein Hormon assoziiert. Die Intensität eines Gefühls leitet sich nicht direkt vom Wert der Körperwahrnehmung ab, die das Gefühl hervorruft, sondern aus der Summe der Wahrnehmung und des Hormonwertes:

Die Hormonwerte können zwar schnell ansteigen, klingen aber langsam wieder ab, so daß der emotionale Zustand noch eine Zeit erhalten bleibt, auch wenn die emotionsauslösende Situation schon längst vorbei ist.

Der mit diesem Emotionssystem ausgerüstete Roboter hat die Aufgabe, in seiner Umgebung verstreute Nahrungsquellen aufzusuchen und Energie zu sich zu nehmen. Je schneller er sich bewegt, desto mehr Energie verbraucht er. Die Nahrungsquellen bestehen aus Lichtern, die der Roboter wahrnehmen kann. Um daraus Energie zu ziehen, muß er die Nahrungsquelle anstoßen. Dies setzt für kurze Zeit Energie frei und zudem einen Geruch, den der Roboter wahrnehmen kann. Um die Energie aufzunehmen, muß der Roboter sich drehen und der Nahrungsquelle seinen Rücken zukehren. Nach einer kurzen Zeit ist die Nahrungsquelle leer und braucht einen gewissen Zeitraum, um sich wieder zu regenerieren. Der Roboter muß also andere Nahrungsquellen aufsuchen. Wenn eine Nahrungsquelle über keine Energie verfügt, geht ihr Licht aus.

Im Rahmen dieser Aufgabe sehen die emotionalen Abhängigkeiten von Gefühlen wie folgt aus:

| Der Roboter ist glücklich (happy), wenn die gegenwärtige Situation keine Probleme aufweist. Er ist besonders glücklich, wenn er seine Motoren viel gebraucht hat oder gerade Energie auftankt. | |

| Der Roboter ist traurig (sad), wenn er wenig Energie hat und gerade keine Energie aufnimmt. | |

| Wenn der Roboter gegen eine Wand fährt, macht ihn der empfundene Schmerz ängstlich (fearful). | |

| Wenn der Roboter zu lange an einer Position verharrt, wird er unruhig. Das macht ihn ärgerlich (angry). Der Ärger bleibt bestehen, bis er sich bewegt oder sein aktuelles Handeln ändert. |

Das System lernt durch Verstärkungslernen (Reinforcement Learning). Um den Lernprozeß zu verkürzen, wurden die grundlegenden Verhaltensweisen des Roboters von vornherein einprogrammiert, damit das System sich auf das Lernen von Verhaltenskoordination konzentrieren konnte. Die drei grundlegenden Verhaltensweisen des Roboters sind die Vermeidung von Hindernissen, das Aufsuchen von Lichtquellen sowie das Fahren an einer Wand entlang.

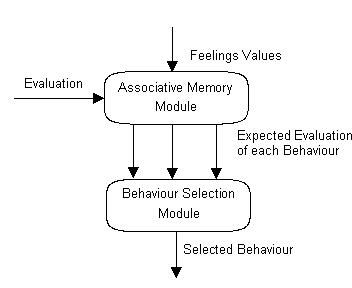

Das System verfügt über einen Controller mit zwei separaten Modulen. Das Associative Memory Module ist ein neuronales Netz, das die Gefühle des Roboters mit den derzeit zu erwartenden Werten jeder seiner drei Verhaltensweisen assoziiert. Der dabei verwendete Algorithmus ist das Q-Learning. Das Behaviour Selection Module trifft aufgrund der Informationen des anderen Moduls eine stochastische Auswahl, welches Verhalten als nächstes ausgeführt werden soll.

Abb. 18: Adaptiver Controller (nach Gadanho und Hallam, 1998, S. 3)

Belohnung oder Bestrafung bei einem autonomen Roboter bergen, so die Autoren, ein besonderes Problem. Von Sekunde zu Sekunde ändern sich die Umwelt oder der interne Zustand des Roboters. Wenn bei jedem Übergang (transition) alle Informationen analysiert und die Verhaltensweisen geändert werden, würde dies nicht nur ungemeine Verarbeitungskapazität kosten, sondern dem Roboter auch keinerlei Rückmeldung darüber liefern, ob ein gewähltes Verhalten vielleicht erst nach einer Reihe von Übergängen zum Erfolg führt. Auf der anderen Seite muß er aber auch dazu in der Lage sein, ein dysfunktionales Verhalten schnell zu ändern. Hier kommen die Emotionen ins Spiel: Ihre Aufgabe soll es sein, diese Zustandsübergänge (state transitions) zu bestimmen.

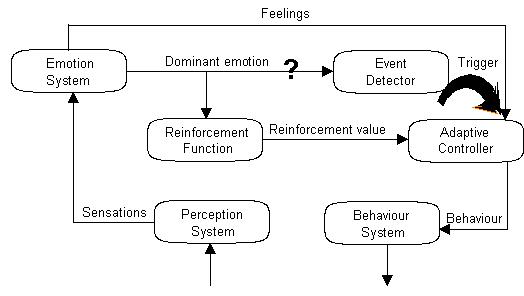

Um diese Hypothese zu testen, entwickelten die Autoren einen Controller mit emotionsabhängiger Ereignisentdeckung (emotion-dependent event detection). Ein Ereignis wird entdeckt, wenn eine von drei Bedingungen eintritt:

| es gibt einen Wechsel der dominanten Emotion; | |

| der Wert der derzeit dominanten Emotion unteschiedet sich statistisch signifikant von den Werten, die seit dem letzten Zustandsübergang aufgezeichnet wurden; | |

eine Grenze von 10.000 Schritten wird

erreicht. |

Abb. 19: Emotionen und Kontrolle (nach Gadanho und Hallam, 1998, S. 4)

Um die Effektivität dieses ereignisgesteuerten Controllers zu testen, entwickelten die Autoren drei weitere Controller:

| Regelmäßige Intervalle (regular intervals) - der adaptive Kontroller wird alle 35 Schritte ausgelöst. | |

| Handgemacht (hand-crafted) - alle Verhaltensweisen sind fest in den Controller einprogrammiert, das System kann nichts lernen. | |

| Zufallsauswahl (random selection) - der Controller wählt bei jedem Schritt ein neues Verhalten aus. |

Jeder dieser vier Controller durchlief einen identischen Versuchsaufbau. Er bestand aus dreißig unterschiedlichen Versuchen mit drei Millionen Lernschritten. In jedem Versuch wurde ein voll aufgeladener Roboter an eine zufällig ausgewählte Startposition gesetzt. Zwecks Evaluation wurden Einheiten zu jeweils 50.000 Schritten evaluiert und Daten über die folgenden Variablen erhoben:

| der Durchschnitt der während aller Schritte erhaltenen Verstärkung; | |

| der Durchschnitt der Verstärkung während der Schritte, in denen der adaptive Controller ausgelöst wurde; | |

| der Durchschnitt des Energieniveaus des Roboters; | |

| die Anzahl der Zusammenstöße; | |

| die Häufigkeit der Auslösung des adaptiven Controllers. |

Das Resultat sieht wie folgt aus:

|

Controller

|

Reinforcement | Event reinforcement | Energy | Collisions (%) | Events (%) |

|

Hand-crafted

|

0.34 | -0.03 | 0.83 | 3.0 | 6.15 |

|

Event-driven

|

0.24 | 0.04 | 0.63 | 0.6 | 0.52 |

|

Regular intervals

|

0.24 | 0.20 | 0.62 | 1.7 | 2.86 |

|

Random selection

|

-0.38 | -0.38 | 0.02 | 5.6 | 100 |

Tab. 9: Ergebnisse der Versuche von Gadanho und Hallam (nach Gadanho und Hallam, 1998, S. 5)

Die Ergebnisse zeigen, so die Autoren, daß die lernenden Controller ihre Aufgabe erfüllt haben. Ihr Energieniveau ist zwar im Schnitt deutlich niedriger, aber erreicht keinen kritischen Wert. Zwischen den beiden lernenden Controllern liegt der Hauptunterschied in der Anzahl der Zusammenstöße - hier ist der ereignisgesteuerte Controller besser.

Insgesamt ist der ereignisgesteuerte Controller nicht deutlich besser als sein Konkurrent, aber er erzielt seinen Lernerfolg mit einer deutlich niedrigeren Zahl an Ereignissen und spart dadurch wesentlich mehr Zeit.

Die Autoren kommen zu dem Schluß, daß die Experimente ihre Hypothese über die Rolle von Emotionen beim Verstärkungslernen bestätigt haben.

11.4. Das Modell von Staller und Petta

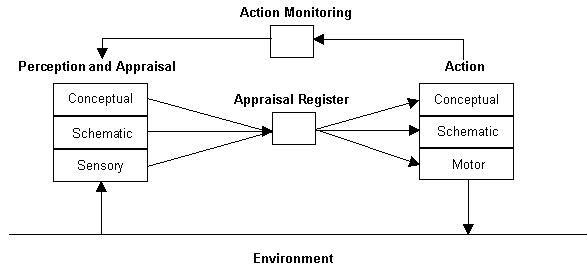

Staller und Petta haben die TABASCO-Architektur entwickelt, ein Akronym für "Tractable Appraisal-Based Architecture for Situated Cognizers" (Staller und Petta, 1998). TABASCO stützt sich größtenteils auf die Emotionstheorie von Scherer und ist bislang noch nicht in einer Simulation implementiert worden.

Staller und Petta fassen Emotionen als Prozesse auf, die in Bezug stehen zur Interaktion eines Agenten mit seiner Umwelt. "In particular, TABASCO models the appraisal process, the generation of action tendencies, and coping." (Staller und Petta, 1998, S. 3)

Die grundlegende Idee von TABASCO besteht darin, daß die von Scherer postulierten Ebenen des Emotionssystems (sensorimotorisch, schematisch und konzeptionell) nicht nur Gültigkeit haben in Bezug auf Einschätzungen, sondern auch in Bezug auf die Handlungsgeneration. Die beiden Hauptkomponenten der Architektur, Perception and Appraisal und Action, sind deshalb als Hierarchien mit drei Ebenen angelegt.

Abb. 20: Die TABASCO-Architektur (nach Staller und Petta, 1998, S. 4)

Die Komponente Perception and Appraisal: Die sensorische Schicht besteht aus Feature-Detektoren zum Entdecken von beispielsweise plötzlichen, intensiven Reizen oder der Qualität eines Reizes (z.B. pleasantness). Die schematische Schicht vergleicht den Input mit Schemata, speziell mit sozialen und Selbstschemata. Die konzeptionelle Schicht kann, auf der Grundlage von propositionalem Wissen und Überzeugungen, abstrakt denken und inferieren.

Die Komponente Action: Die motorische Schicht enthält motorische Kommandos. Die schematische Schicht enthält Handlungstendenzen und die von Frijda so genannten "flexible programs" (Frijda, 1986, S. 83). Die konzeptionelle Schicht ist zuständig für coping.

Zwischen diesen beiden Komponenten moderiert das Appraisal Register, das auf einen Vorschlag von Smith et al. (1996) zurückgeht. Es entdeckt und kombiniert die Einschätzungsergebnisse der drei Schichten der Perception and Appraisal-Komponente und beeinflußt, auf der Grundlage des eingeschätzten Zustands, die Action-Komponente.

Die Action Monitoring-Komponente schließlich beobachtet die Planungs- und Ausführungsprozesse der Action-Komponente und übermittelt die Ergebnisse an die Perception andAppraisal-Komponente, wo sie in den Einschätzungsprozeß integriert werden.

Staller und Petta bezeichnen ihr System als einen situated cognizer. Damit wollen sie die Bedeutung beider Komponenten für ein autonomes System unterstreichen. Sie definieren cognizing (ein zuerst von Chomsky vorgeschlagener Begriff) als "having access to knowledge that is not necessarily accessible to consciousness" (Staller und Petta, 1998, S. 5).

11.5. Das Modell von Botelho und Coelho

Botelho und Coelho definieren Emotion im Rahmen ihres Salt & Pepper-Projekts als "a process that involves appraisal stages, generation of signals used to regulate the agent's behavior, and emotional responses" (Botelho und Coelho, 1997, S.4). Mit Salt & Pepper soll eine Architektur definiert werden, die Mechanismen enthält, welche für autonome Agenten dieselbe Rolle spielen wie die Mechanismen, die Menschen so erfolgreich machen.

Ausgangspunkt ihrer Überlegungen ist die Klassifikation von Emotionen in einer mehrdimensionalen Matrix "that may be used with any set of emotion classification dimensions" (Botelho und Coelho, 1997, S. 4).

| Dimension of classification | Examples | Process component |

| Role/function of emotion | Attention shift warning, performance evaluation, malfunctioning-component warning, motivation intensifier | Emotion-signal |

| Process by which emotion fulfills its role | Reflexive action, creation of motivators, setting plan selection criteria | Emotion-response |

| Urgency of the repairing process | Urgent (e.g. need to immediately attend the external environment), not urgent (e.g. need for long-term improvement of default criteria for plan selection) | Emotion-response |

| Source of appraisal | External environment, internal state, past events, current events | Appraisal stage |

| Type of appraisal | Affective appraisal, cognitive appraisal | Appraisal stage |

Tab. 10: Dimensionen der Emotionsklassifikation (nach Botelho und Coelho, 1997, S. 5)

Die Autoren unterscheiden zwischen affektiver und kognitiver Einschätzung und behaupten, daß es prinzipiell möglich sei, in einer gegebenen Architektur zwischen diesen beiden Komponenten klar zu unterscheiden. Sie bezeichnen die entsprechenden Module als Affective Engine und Cognitive Engine.

Die Affective Engine und die Cognitive Engine unterscheiden sich in drei Aspekten:

- Art der verarbeiteten Information: Die Affective Engine verarbeitet Information, die mit der hypothetischen oder wirklichen Befriedbarkeit (satisfiability) der Motive des Agenten zu tun hat, während die Cognitive Engine zusätzlich noch Problemlösungsinformationen, Entscheidungsinformationen und deklarative Informationen über unterschiedliche Aspekte der Welt verarbeitet.

- Ziel der Informationsverarbeitung: Das Hauptziel der Informationsverarbeitung der Affective Engine ist die Erzeugung von Signalen, die der Cognitive Engine dabei helfen, ihre Aufgaben zu erfüllen, zum Beispiel Auswahl der für eine Situation relevanten kognitiven Strukturen, Kontrolle der Aufmerksamkeit usw. Die Hauptziele der Cognitive Engine sind Zielerreichung, Problemlösung und Entscheiden. "A simple way to put it is to say the Cognitive Engine reasons at the object level, whereas the Affective Engine reasons at the meta-level." (Botelho und Coelho, 1997, S. 10).

- Typische Reaktionszeit: Die Affective Engine reagiert viel schneller als die Cognitive Engine, weil sie nur einen Bruchteil der Information benötigt und ihre Architektur ebenfalls zu schnelleren Entscheidungen beiträgt.

Die Autoren schlagen einen Mechanismus vor, durch den die Affective Engine die Möglichkeit erhält, schnell zu reagieren: die Reduktion expliziter und langer Vergleichsketten zu kurzen, spezifischen Regeln. Sie nennen ein Beispiel für einen solchen Prozeß:

if someone risks dying, he or she will feel a lot of fear;

risks_dying(A) -> activate(fear, negative, 15)

if someone risks running out of food, he or she risks dying;

risks_running_out_of_food(A) -> risks_dying(A)

if someone risks running out of money, he or she risks running out of food;

risks_running_out_of_money(A) -> risks_running_out_of_food(A)

if someone loses some amount of money, he or she risks running out of money;

loses_money(A) -> risks_running_out_of-money(A)

loses_money(A) -> activate(fear, negative,15)

(Botelho und Coelho, 1997, S. 11)

Diese expliziten und impliziten Regeln sollten in einer Hierarchie organisiert sein, in der die längeren Regeln nur dann verwendet werden, wenn keine kurze passende Regel gefunden wird.

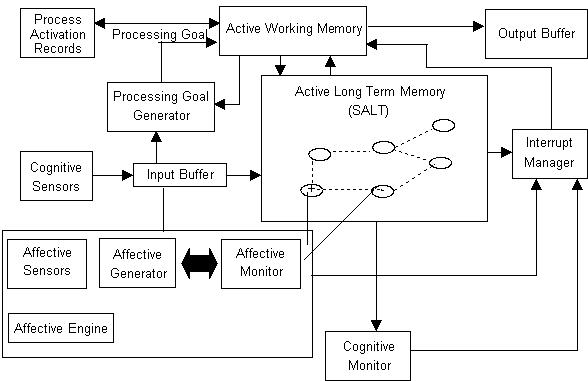

Die Salt & Pepper-Architektur besteht aus drei wesentlichen Komponenten: der Affective Engine, der Cognitive Engine und einem Interrupt Manager. Die Affective Engine verfügt über Affective Sensors, einen Affective Generator und einen Affective Monitor. Die letzten zwei initiieren den Prozeß der Emotionserzeugung gemeinsam. Alle anderen Module des Systems (außer dem Interrupt Manager) sind der Cognitive Engine zuzurechnen.

Abb. 21: Salt & Pepper-Architektur (nach Botelho und Coelho, 1997, S. 12)

Das Langzeitgedächtnis ist ein assoziatives Netzwerk. Jeder Knoten des Netzwerks besitzt eine Identifikation, ein Aktivationsniveau, eine Reihe von Assoziationen mit anderen Knoten und eine Reihe symbolischer Strukturen, die Motive, Pläne, Handlungen und deklaratives Wissen repräsentieren. Je mehr ein Knoten aktiviert ist, desto eher fällt er bei einem Suchprozeß auf (accessability).

Der Input Buffer and der Affective Generator aktivieren Knoten im Langzeitgedächtnis. Der Cognitive Monitor und der Affective Monitor schlagen bestimmte Knoten für die Aufmerksamkeit des Agenten vor. Immer, wenn ein solcher Vorschlagsprozeß läuft, entscheidet der Interrupt Manager, ob der gerade laufende kognitive Vorgang unterbrochen und der Inhalt des vorgeschlagenen Knotens in den Arbeitsspeicher geladen werden soll, um verarbeitet zu werden. Wenn die Inhalte eines Knotens im Arbeitsspeicher verarbeitet werden, erhält der Knoten ein gewisses Maß an Aktivierung und damit mehr accessability.

Knoten, die auf bestimmten Erfahrungen des Agenten beruhen, heißen episodische Knoten und bilden das episodische Gedächtnis.

Emotionen werden in diesem System durch eine Reihe von Parametern beschrieben:

- ein Label E, das die Emotionsklasse und eine Liste von Argumenten beschreibt, zum Beispiel die Quelle der Einschätzung;

- eine Valenz V, die die Werte positiv, negativ oder neutral annehmen kann;

- eine Intensität I;

- ein Emotionsprogramm P, das eine Handlungsabfolge repräsentiert, die ausgeführt wird, sobald die Einschätzungsstufe ein Label produziert hat;

- eine emotionale Reaktion R, die nur ausgeführt wird, wenn ein Knoten im Langzeitgedächtnis, der mit dem Label der Emotion übereinstimmt, ausgewählt und im Arbeitsspeicher verarbeitet wird.

Das Emotionsprogramm unterscheidet sich von der emotionalen Reaktion dadurch, daß es vom Affective Generator ausgeführt wird, ohne die laufende kognitive Verarbeitung des Agenten zu unterbrechen.

Der Affective Generator führt eine teilweise Evaluation des externen und internen Zustands des Agenten durch, die sogenannte affektive Einschätzung. Wenn die Aufrufbedingungen einer bestimmten Emotion erfüllt werden, erzeugt der Affective Generator das Label, die Intensität und die Valenz der Emotion und führt das Emotionsprogramm aus. Der Affective Monitor durchsucht dann das Langzeitgedächtnis, bis er einen Knoten findet, der dem Label der Emotion entspricht und dieselbe Valenz besitzt. Er aktiviert ihn mit einem Aktivationsniveau, das eine Funktion der erzeugten Emotionsintensität darstellt.

Das System verfügt über Mechanismen, die es ihm ermöglichen, emotional zu lernen. Die Autoren unterscheiden zwischen drei Klassen von emotionalem Lernen:

- Lernen von neuen und Optimierung von Einschätzungsregeln: Dazu zählen das Erlernen von neuen Umständen, die ein Emotionssignal auslösen können, die Reduktion von Einschätzungsregeln (s.o.) und die Veränderung der Charakterisitk des generierten Emotionssignals.

- Erweiterung des Repertoires an Emotionssignalen.

- Erlernen von emotionalen Reaktionen: Dazu zählen die Optimierung bestehender Verhaltensreaktionen, das Erlernen neuer Reaktionen sowie Lernen als Ergebnis einer Reaktion auf ein Emotionssignal.

Die Autoren spezifizieren die Voraussetzungen, unter denen ein System in der Lage ist, diese Lernvorgänge durchzuführen (Botelho und Coelho, 1998).

Einige Elemente von Salt & Pepper sind bislang implementiert worden und haben, so die Autoren, die theoretischen Annahmen bestätigt (Botelho und Coelho, 1997).

11.6. Das Modell von Canamero

Canamero (1997) verfolgt ebenfalls einen Ansatz, der auf Minskys "Society of Mind" (1985) basiert. In einer zweidimensionalen Welt namens Gridland leben die Abbotts, künstliche Lebewesen, die auch über ein motivationales und emotionales System verfügen.

Ein Abbott besteht dabei aus einer Vielzahl von Agenten, die, jeder für sich genommen, "simpel" sind, im Zusammenspiel aber eine neue Qualität erreichen. Ein Abbott besitzt drei Arten von Sensoren (somatisch, taktil, visuell); zwei Arten von recognizers, die auf komplexe Reize reagieren und sowohl lernen als auch vergessen können; acht sogenannte direction-nemes, die Informationen aus der räumlichen Umgebung des Abbotts liefern; zwei Kategorien von maps (taktil und visuell), die ihre Informationen von den recognizers und direction-nemes beziehen und diese intern repräsentieren; drei Effektoren (Hand, Fuß, Mund); ein Verhaltensrepertoire (Attack, Drink, Eat, Play, Rest, Withdraw usw.) sowie eine Reihe von managers (z.B. finder, look-for, go-toward), die mit appetitivem Verhalten korrespondieren. Zudem verfügen die Abbotts über eine Reihe von physiologischen Variablen, z.B. Adrenalin, Blutzucker, Endorphine, Körpertemperatur usw.

Die Abbotts bewegen sich in einer Welt, in der es Nahrungsquellen und Hindernisse gibt sowie Feinde. Sie kommen als "Neugeborene" mit einer Basisausstattung an Eigenschaften in diese Welt und müssen sich dann in ihrer Umwelt entwickeln.

Interessant am Modell von Canamero ist, daß ihre Kreaturen von Anfang an mit Motivationen und Emotionen ausgestattet sind. Sie werden, nach Minsky, proto-specialists genannt, weil es sich bei ihnen um primitive Mechanismen handelt, die zuständig sind für Handlungsauswahl und Kontrollfunktionen.

Theoretische Grundlage für die Motivationen ist ein homöostatischer Ansatz:

Die Motivationsagenten der Abbotts bestehen aus

So ruft zum Beispiel die Fehlermeldung "zu niedriger Blutzucker" die Motivation Hunger auf, deren Ziel es ist, den Blutzuckerspiegel zu erhöhen. Die Aktivierung einer Motivation ist proportional zur Größe der Fehlermeldung (bzw. Abweichung eines physiologischen Wertes vom homöostatischen Zustand); aufgrund des Aktivationsniveaus wird zudem die Intensität der Motivation berechnet. Die Motivation mit dem höchsten Aktivationsniveau versucht, das Verhalten des Abbotts so zu organisieren, daß der zugehörige Trieb befriedigt wird. Wenn die Motivation kein entsprechendes Verhalten finden und aufrufen kann, aktiviert sie den finder agent und übergibt ihm den Intensitätswert, damit er ihn an andere Agenten weiterreichen kann, die von ihm aktiviert werden. Die Intensität beeinflußt ein Verhalten wesentlich: beim Fluchtverhalten zum Beispiel die Stärke der motorischen Aktivität, bei anderen Verhalten zum Beispiel deren Dauer.

Aktivationsniveau und Intensität einer Motivation können nun von Emotionen modifiziert werden. In Canameros System bestehen Emotionen aus

Emotionale Zustände werden aktiviert und voneinander unterschieden durch drei Arten von Auslösern:

- Externale Ereignisse, also ein Objekt oder das Ergebnis eines Verhaltens, wobei die Reaktion darauf entweder angeboren oder erlernt sein kann.

- Generelle Stimulationsmuster, die verschiedene Veränderungen in den physiologischen Variablen hervorrufen und damit dieselbe Emotion in unterschiedlichen Umständen wirken lassen. Als Beispiel nennt Canamero den anger agent, der durch ein fortdauernd zu hohes Niveau einer Variablen aufgerufen wird. Dadurch tragen Emotionen zur Kontrolle homöostatischer Prozesse bei.

- Spezielle Wertemuster physiologischer Variablen, die eine Unterscheidung zwischen Emotionen zulassen, die durch denselben generellen Mechanismus hervorgerufen werden. Als Beispiel nennt Canamero Angst (mit hoher Herzschlagfrequenz) und Interesse (mit niedriger Herzschlagfrequenz).

Da Abbott ein primitives System ist, befindet es sich stets in einem eindeutigen emotionalen Zustand. Die drei Auslöser sind in der Reihenfolge der obigen Aufzählung hierarchisch gegliedert. Die ausgewählte Emotion beeinflußt den Handlungsauswahlmechanismus auf zwei Arten: Sie kann die Intensität der aktuellen Motivation senken oder erhöhen und damit zugleich auch die Intensität des ausgewählten Verhaltens; zudem modifiziert sie die Resultate der Sensoren, welche die Variablen messen, die die Emotion beeinflussen und ändert damit den wahrgenommenen körperlichen Zustand (happiness agent -> Freisetzung von Endorphin -> geringere Schmerzwahrnehmung).

Die Handlungsauswahl eines Abbotts erfolgt somit in vier Stufen:

- Das Aktivationsniveau aller Agenten wird auf Null gesetzt.

- Interne Variablen und Umweltdaten werden eingelesen und maps werden gebildet.

- Motivationen werden eingeschätzt und die Auswirkungen des emotionalen Zustands werden berechnet. Die Motivation mit der höchsten Aktivation wird ausgewählt.

- Die aktive Motivation selektiert das oder die Verhalten, die ihren Trieb am besten befriedigen können.

Canamero räumt ein, daß ihre Abbotts derzeit noch auf einem sehr primitiven Niveau operieren und eine Reihe zusätzlicher Agenten benötigen, um auch langfristiges Lernen und Strategien zu entwickeln. Dabei spielen in ihrem Modell Emotionen eine wesentliche Rolle:

11.7. Zusammenfassung und Bewertung

Wie die vorangegangenen Beispiele zeigen, gibt es im Bereich der autonomen Agenten inzwischen eine Vielfalt von Ansätzen, Emotionen zu modellieren. Die Bezüge zur psychologischen Theorie sind dabei unterschiedlich ausgeprägt.

Es fällt auf, daß die meisten Autoren bei ihren theoretischen Anleihen recht eklektizistisch vorgehen. Zurückgegriffen wird vorwiegend auf die Theorien, die sich gut für eine Operationalisierung eignen. Dabei werden häufig nur bestimmte Elemente herausgegriffen, die dann um eigene Komponenten erweitert werden, oft ohne daß dies explizit deutlich gemacht wird.

Um schnelle Ergebnisse zu erzielen, werden von den entworfenen Modellen wiederum nur Teilbereiche in wirkliche Simulationen oder Roboter implementiert. Dabei werden pragmatische Lösungen eingesetzt, die komplexe Prozesse notwendigerweise auf einige wenige Variablen reduzieren. Diese Variablen werden zudem noch häufig willkürlich definiert, um das Modell überhaupt umsetzen zu können.

Auffallend ist, daß die Mehrheit der Autoren Emotionen als einen wesentlichen Bestandteil des Kontrollsystems eines Agenten betrachtet und sie in dieser Hinsicht funktional definiert. Emotionen werden nicht mehr als Anhängsel des kognitiven Systems betrachtet, sondern inzwischen eher als unverzichtbare Voraussetzung für das zuverlässige Funktionieren von Kognition.

Eine Betrachtung der Modelle zeigt allerdings auch, daß alle noch weit davon entfernt sind, den postulierten Anspruch auch in die Wirklichkeit umsetzen zu können.